Les deepfakes en 2025 : menace réelle ou peur exagérée ?

Depuis quelques années, le terme « deepfake » est passé du jargon technique des laboratoires d’intelligence artificielle aux conversations quotidiennes. En 2025, la technologie est devenue si performante qu’il est presque impossible, à l’œil nu, de distinguer une vidéo authentique d’un montage synthétique. Cette évolution pose une question cruciale : sommes-nous réellement face à un danger imminent pour nos sociétés, ou succombons-nous à une peur amplifiée par le sensationnalisme médiatique ?

Une technologie à la croisée des intelligences artificielles

Le deepfake repose sur l’apprentissage profond, ou deep learning, qui permet à un réseau neuronal de reproduire la voix, le visage ou les gestes d’une personne à partir d’un grand volume de données existantes. En 2025, les algorithmes génératifs, tels que les GAN (Generative Adversarial Networks) et les modèles de diffusion, sont devenus bien plus rapides et accessibles. Un ordinateur portable standard ou même un smartphone haut de gamme est désormais capable de créer en quelques minutes des vidéos truquées d’une qualité quasi-professionnelle.

L’accessibilité de ces outils a transformé ce qui était, il y a cinq ans, une prouesse technique réservée à une poignée de chercheurs, en un phénomène potentiellement à la portée de millions d’internautes.

Entre usages créatifs et dérives inquiétantes

Comme toute avancée technologique, le deepfake n’est pas intrinsèquement « bon » ou « mauvais ». Les studios de cinéma, les créateurs de contenus et les musées exploitent cette technologie pour recréer des scènes historiques ou redonner vie à des personnalités disparues. Des campagnes de communication utilisent des avatars réalistes pour incarner des messages sans mobiliser d’acteurs physiques, réduisant ainsi les coûts et l’empreinte écologique.

Cependant, ces usages vertueux coexistent avec des dérives préoccupantes. Les deepfakes à caractère pornographique, les manipulations politiques ou encore les escroqueries en ligne exploitant la voix et le visage de dirigeants ou de proches sont déjà documentés. L’impact psychologique sur les victimes est lourd, allant de la perte de réputation à des traumatismes durables.

La frontière de plus en plus floue entre vrai et faux

L’une des principales inquiétudes réside dans l’érosion de la confiance envers l’image et le son comme preuves. En 2025, une séquence vidéo ne peut plus être considérée comme une preuve incontestable devant un tribunal sans analyse technique approfondie. Les journalistes, les enquêteurs et les citoyens doivent désormais intégrer un réflexe de vérification systématique.

Cette perte de repères nourrit un climat où la désinformation peut prospérer.

Ce phénomène, parfois appelé « infocalypse », risque de banaliser la contestation systématique des images gênantes, même lorsqu’elles sont authentiques. En d’autres termes, le deepfake ne se contente pas de fabriquer de faux contenus : il peut aussi servir à nier le vrai.

L’arsenal de la détection et ses limites

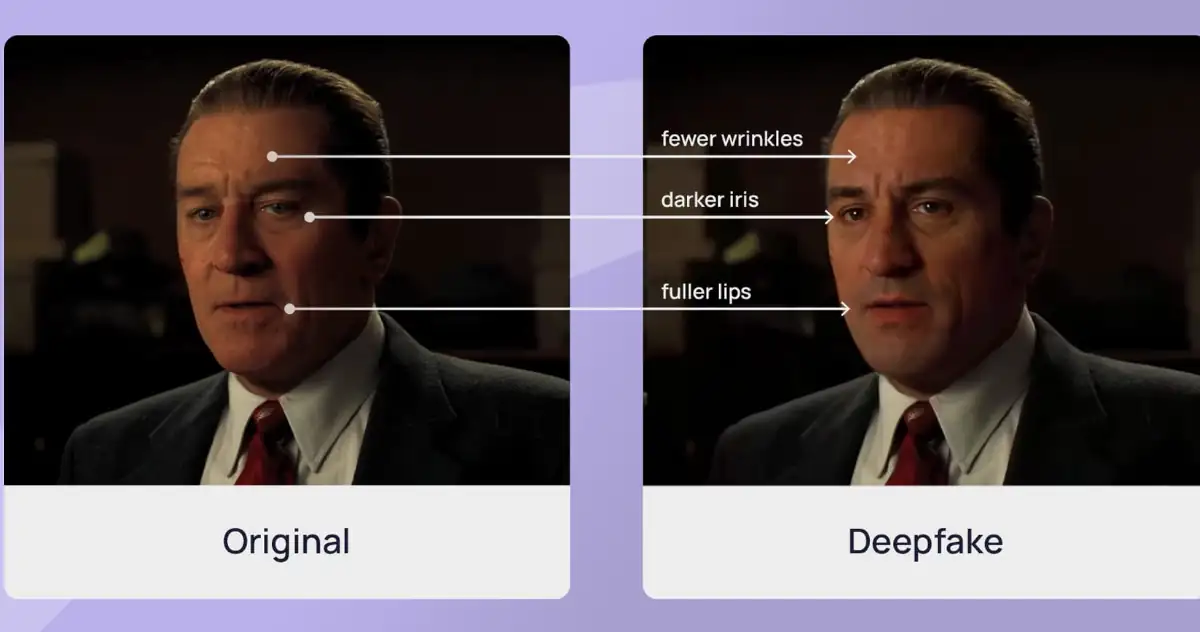

Face à la menace, la recherche en détection de deepfakes s’intensifie. Des systèmes d’analyse automatique cherchent à repérer des anomalies invisibles à l’œil nu, comme des incohérences dans les clignements des yeux, des micro-expressions faciales improbables ou des artefacts visuels microscopiques.

Cependant, la course est à double sens : chaque progrès dans la détection est rapidement contourné par de nouvelles techniques de génération. Les plateformes sociales tentent de mettre en place des filtres automatisés, mais les faux passent encore à travers. Certains gouvernements imposent des obligations de traçabilité numérique des vidéos, grâce à des signatures invisibles insérées lors de la capture originale.

Un risque réel… mais souvent amplifié

Si les deepfakes peuvent effectivement causer des dégâts considérables, leur danger immédiat reste limité par rapport à d’autres formes de désinformation plus simples et moins coûteuses à produire, comme les montages photo ou les rumeurs textuelles. Une vidéo truquée sophistiquée nécessite encore un minimum de compétences, même si la tendance est à la démocratisation.

Le risque majeur réside dans la combinaison de cette technologie avec des campagnes de désinformation coordonnées. Dans ce cadre, un deepfake bien diffusé peut influencer l’opinion publique, déclencher des tensions diplomatiques ou saboter des processus démocratiques. Mais dans la majorité des cas recensés en 2025, les deepfakes restent confinés à des sphères spécifiques, comme la cybercriminalité ciblée ou les atteintes à la vie privée.

Vers un nouvel équilibre entre vigilance et sérénité

Plutôt que de céder à la panique, les experts invitent à développer une culture numérique fondée sur la vérification, la prudence et l’esprit critique. La formation à la littératie médiatique, l’amélioration des outils de détection et la mise en place de cadres juridiques adaptés sont autant de leviers pour limiter l’impact négatif de cette technologie.

La peur excessive, en revanche, pourrait mener à un contrôle excessif des contenus et à une limitation disproportionnée de la liberté d’expression. L’enjeu, pour les années à venir, sera donc de trouver un équilibre entre protection et préservation des libertés fondamentales.

Tableau récapitulatif : Deepfakes en 2025

| Aspect | État actuel | Risques principaux | Solutions envisagées |

|---|---|---|---|

| Accessibilité | Outils grand public, création rapide et peu coûteuse | Diffusion massive de contenus truqués | Sensibilisation, encadrement légal |

| Usages positifs | Cinéma, pédagogie, reconstitution historique | Risque de confusion avec des usages malveillants | Marquage numérique, transparence |

| Menaces majeures | Escroquerie, manipulation politique, atteintes à la vie privée | Perte de confiance dans les images | Vérification systématique, IA de détection |

| Détection | Progrès rapides mais contournables | Course technologique sans fin | Collaboration internationale, normes techniques |

| Perception publique | Méfiance accrue | Risque de rejet des images authentiques | Éducation à l’esprit critique |

Sources :

- Chesney, R., Citron, D.K. (2023). Deepfakes and the New Disinformation War. Harvard Law Review.

- Paris, B., Donovan, J. (2024). The Threat of Deepfakes in Politics. MIT Technology Review.

- Smith, A. (2025). Synthetic Media in the Age of AI. Oxford University Press.

Pour aller plus loin :

Préparer la rentrée numérique 2025 des enfants

Les Merveilles et les Limites de l’IA Générative

Notre confiance dans les smartphones chinois ?

Sécurité des smartphones : sommes-nous à l’abri ?